Robots.txt – это текстовый файл, который позволяет веб-мастерам контролировать взаимодействие роботов-поисковиков с их сайтом. Этот индексный файл настраивает правила для поисковых систем, указывая, какие страницы сайта могут быть проиндексированы, а какие нет. Таким образом, robots.txt позволяет web-мастерам контролировать индексацию своего сайта и предотвращает попадание в поисковые результаты страниц, которые не должны быть видны публично.

Robots.txt предлагает поисковым роботам следовать определенным инструкциям, позволяет указать, какие страницы и разделы сайта нужно индексировать, а какие – нет. По сути, это договор между веб-мастером и поисковыми системами. Благодаря использованию robots.txt можно спрятать от индексации страницы, содержащие личную информацию, информацию для внутреннего пользования сайта, дублированные страницы, временные страницы и т.д.

Индексация содержимого происходит с помощью роботов (crawler-ов). Эти программы проходят по всем веб-страницам в соответствии с указаниями в robots.txt. В случае отсутствия индексного файла, crawler просматривает все страницы сайта. Однако, в случае наличия файла robots.txt, crawler сначала проверяет инструкции в этом файле и выполняет их. Таким образом, robots.txt эффективно контролирует индексацию и обеспечиваеет более эффективное использование ресурсов поисковых систем, и улучшает процесс поиска и качество результатов для конечных пользователей.

Что такое файл robots.txt?

Robots.txt — это удобный инструмент для веб-мастеров, поскольку позволяет влиять на процесс индексации сайта поисковыми системами. Он позволяет исключить определенные части сайта от индексации, чтобы предотвратить попадание нежелательной информации в поисковые результаты, а также управлять частотой и скоростью обхода страниц роботами.

Синтаксис файла robots.txt

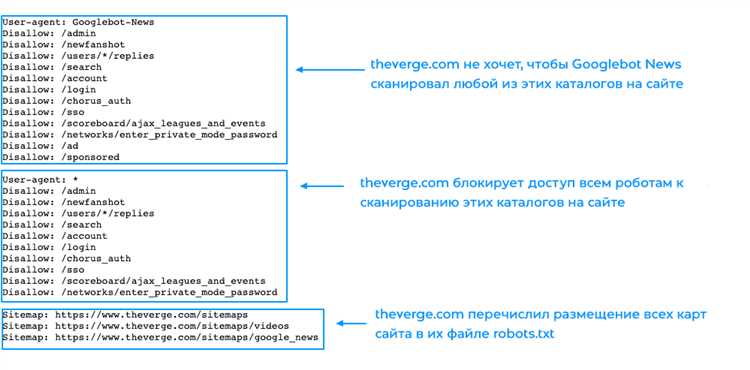

Файл robots.txt состоит из набора правил, каждое из которых состоит из двух частей: User-agent и Disallow (или Allow). User-agent указывает на имя робота, для которого действуют правила, а Disallow указывает на путь к странице или директории, которую нужно исключить из индексации. Можно также использовать Allow для разрешения индексации конкретных страниц.

Пример:

- User-agent: *

- Disallow: /private/

- Disallow: /admin/

В этом примере указывается, что все роботы (*) должны исключать индексацию страниц, находящихся в директориях /private/ и /admin/.

Зачем нужен индексный файл для сайта?

Основная функция индексного файла заключается в том, чтобы предоставить поисковым роботам информацию о том, как они должны взаимодействовать с сайтом. С помощью индексного файла вы можете ограничивать доступ поисковых роботов к определенным разделам сайта, запрещать индексацию конкретных страниц или файлов, а также указывать на наличие карты сайта или других важных ресурсов.

Индексный файл особенно полезен, если у вас есть разделы сайта, которые вы не хотите показывать в поисковых результатах. Например, это может быть административная панель сайта или временный раздел, который еще не готов к публикации. Используя индексный файл, вы можете легко и эффективно скрыть эти разделы от поисковых роботов, не позволяя им индексировать эту информацию.

Кроме того, индексный файл также может быть использован для закрытия доступа к конфиденциальным страницам или файлам, которые вы хотите ограничить только для определенных пользователей, например, залогиненных администраторов сайта.

В целом, индексный файл является мощным инструментом, который позволяет вам контролировать индексацию и доступность различных разделов вашего сайта для поисковых роботов. Корректное использование индексного файла может помочь вам улучшить видимость вашего сайта в поисковых системах и обеспечить более эффективное индексирование и ранжирование страниц сайта.

Основные правила robots.txt

Вот несколько основных правил, которые стоит учитывать при работе с robots.txt:

-

Используйте правильное имя файла: Файл должен называться robots.txt и располагаться в корневой папке сайта. Так поисковые системы смогут автоматически найти и прочитать файл.

-

Указывайте директивы для всех типов роботов: В файле robots.txt можно указывать инструкции для разных типов роботов. Но необходимо помнить, что не все роботы обязательно будут следовать этим инструкциям.

-

Будьте внимательны при указании запретов: Ошибочные запреты могут привести к некорректной индексации и исключению нужных страниц из поисковой выдачи. Проверьте, что запреты указаны корректно и не исключают важные разделы или страницы сайта.

-

Используйте комментарии: В файле можно использовать комментарии, чтобы описывать и пояснять директивы. Это упростит понимание файла другим разработчикам и специалистам.

-

Не используйте robots.txt для скрытия содержимого: Файл robots.txt используется для указания инструкций роботам по индексации, но не для скрытия информации от пользователей. Если вам требуется скрыть часть контента от поисковых систем, используйте другие методы, например, мета-теги noindex или password protection.

Не забывайте, что robots.txt является всего лишь рекомендацией для поисковых систем, и роботы поисковых систем могут не всегда следовать указанным инструкциям. Поэтому, помимо правильной настройки robots.txt, также важно следить за другими аспектами оптимизации сайта, такими как качественный контент, удобная навигация и скорость загрузки страниц.